¿Qué tan ético está siendo el uso de la inteligencia artificial?

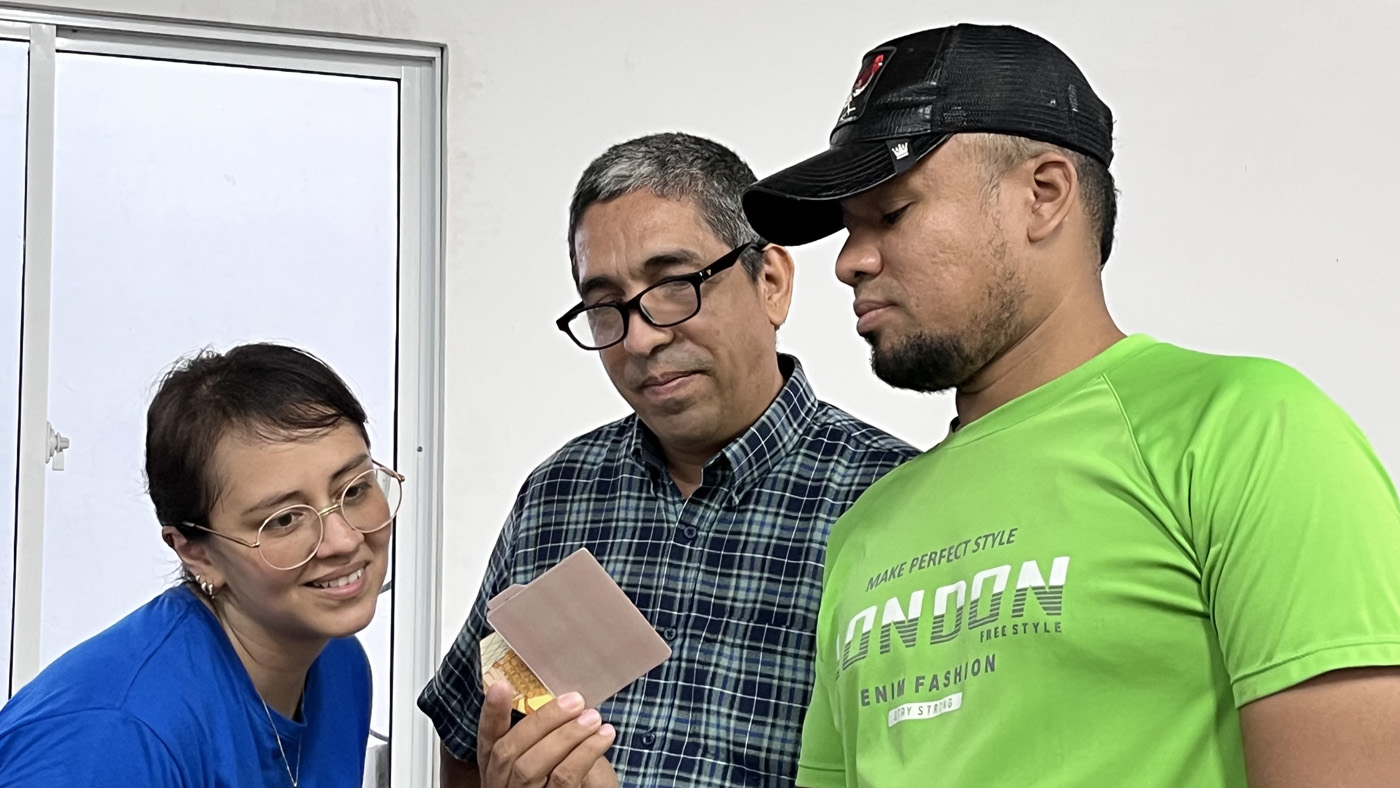

Docentes y estudiantes de Tumaco participaron en el taller ofrecido por UNALab. Fotos: Andrea Ojeda, Unimedios Tumaco.

La capacitación a las personas en IA es muy importante para que tomen buenas decisiones a la hora de utilizar o no esta tecnología. Foto: Aula STEAM Sede Tumaco.

Es importante abrir espacios de reflexión dirigidos a estudiantes y comunidad en general sobre los retos y riesgos de usar la IA. Foto: Andrea Ojeda, Unimedios Tumaco.

UNALab y la UNAL Sede Tumaco realizaron talleres de capacitación en IA para estudiantes de colegios y universidades. Foto: Andrea Ojeda, Unimedios Tumaco.

Los talleres teórico-prácticos buscan aportar a la compresión de la IA más allá de los estrictamente tecnológico. Foto: Andrea Ojeda, Unimedios Tumaco.

Por eso es urgente que Colombia adopte y promueva una reglamentación que considere los aspectos éticos del uso de la IA en los diferentes sectores sociales y económicos, además de la responsabilidad por los daños que este uso pueda causar, la transparencia de los algoritmos y la sostenibilidad y responsabilidad social al emplear esta tecnología. Así lo expresaron los expertos invitados al taller teórico-práctico sobre IA dictado en la Universidad Nacional de Colombia (UNAL) Sede Tumaco.

Según el abogado Edwin Cicery, de la División Universidad Laboratorio (UNALab) de la UNAL, “como herramienta, la IA se puede usar según parámetros legales y éticos, los cuales están en discusión y construcción en el mundo, con avances significativos en algunos países; sin embargo en Colombia esta es más reciente, y por ahora el país cuenta con la ‘Hoja de la ruta para el desarrollo y la aplicación de la inteligencia artificial’, aprobada en febrero pasado”.

Dicho documento estratégico, aprobado por el Ministerio de Ciencia, Tecnología e Innovación, guiará el desarrollo de políticas, acciones y decisiones del Gobierno nacional hacia un futuro impulsado por la tecnología, pero siempre arraigado en principios éticos y sostenibles.

En el taller –dirigido tanto a la comunidad universitaria como a colegios, entidades y empresarios de Tumaco– se habló de los desafíos éticos, entre los que se encuentran el uso indebido de los sistemas (manipulación de datos o explotación de poblaciones vulnerables); las armas para infligir daños potencialmente irreversibles; el sesgo (presencia de prejuicios sistemáticos como discriminación racial, de género, edad y otros), e incluso la invasión de la privacidad (recopilación de información sensible, hábitos de consumo, ubicación, historial de búsqueda y conversaciones privadas).

Un ejemplo de manipulación de datos es el uso de algoritmos en el proceso de selección de personal que pueden generar discriminación. Aunque las plataformas utilizan algoritmos para analizar currículums y seleccionar candidatos, estos pueden estar sesgados hacia ciertos perfiles y excluir a personas de diferentes orígenes o con trayectorias no convencionales. Precisamente esto sucedió en la empresa IBM cuando su sistema de reconocimiento facial mostró un sesgo racial al tener dificultades para reconocer adecuadamente a personas de piel más oscura.

En Colombia se ha detectado que los pedófilos suplantan clandestinamente la identidad de niños reales en videos pornográficos hechos con IA, interactúan en las diversas plataformas y crean canales de comunicación para contactarlos con los cibercriminales.

También se cuentan la manipulación y desinformación usada para crear y difundir información falsa o manipulada, como noticias falsas (fakenews) o videos alterados que parecen reales.

El abogado Cicery, magíster en Propiedad Intelectual, destaca que “los riesgos más latentes desde el punto de vista legal se relacionan con sesgo y equidad; protección de datos y privacidad; y derechos de propiedad intelectual derivados del uso de esta tecnología”.

“Por eso es necesario adoptar una gobernanza ética que reglamente los aspectos éticos del uso de la IA en los diferentes sectores, que vigile la transparencia de los algoritmos y el funcionamiento de la IA, la sostenibilidad y la responsabilidad social al momento de usarla”.

En ese sentido, el objetivo del taller realizado en la Sede Tumaco es proporcionar espacios de reflexión y análisis sobre los impactos sociales y culturales y sobre las cuestiones éticas que rodean la IA.

Alejandra Torres, directora creativa de Vórtico, proveedor de apoyo de UNALab, anota que “en el taller se desarrollaron varios espacios con estudiantes, docentes y comunidad en general para sensibilizar sobre qué es la IA, cuáles son sus implicaciones éticas en la toma de decisiones y sus sesgos cognitivos”.

Los expertos de UNALab consideran muy importante capacitar a las personas para que tomen buenas decisiones a la hora de utilizar o no esta tecnología. “Ante una amplia oferta de IA, se deben entender su funcionamiento y su lógica para poder tomar esas decisiones personales (ética y moral) a la hora de utilizarla, y desde el punto de vista técnico, analizar su implementación en los diferentes campos”, agregó la directora Torres, especialista en creación e innovación.